【已解决】如何在服务器中下载huggingface模型,解决huggingface无法连接

问题说明

在服务器上使用huggingface模型时,如果直接指定模型名称,用AutoTokenizer.from_pretrained(“model_name”),可能会由于网络原因会报错 Failed to connect to huggingface.co port 443 after 75018 ms: Operation time out

因此我们需要下载模型到服务器上,得到模型本地的路径model_dir,再通过AutoTokenizer.from_pretrained(model_dir)方式来使用。

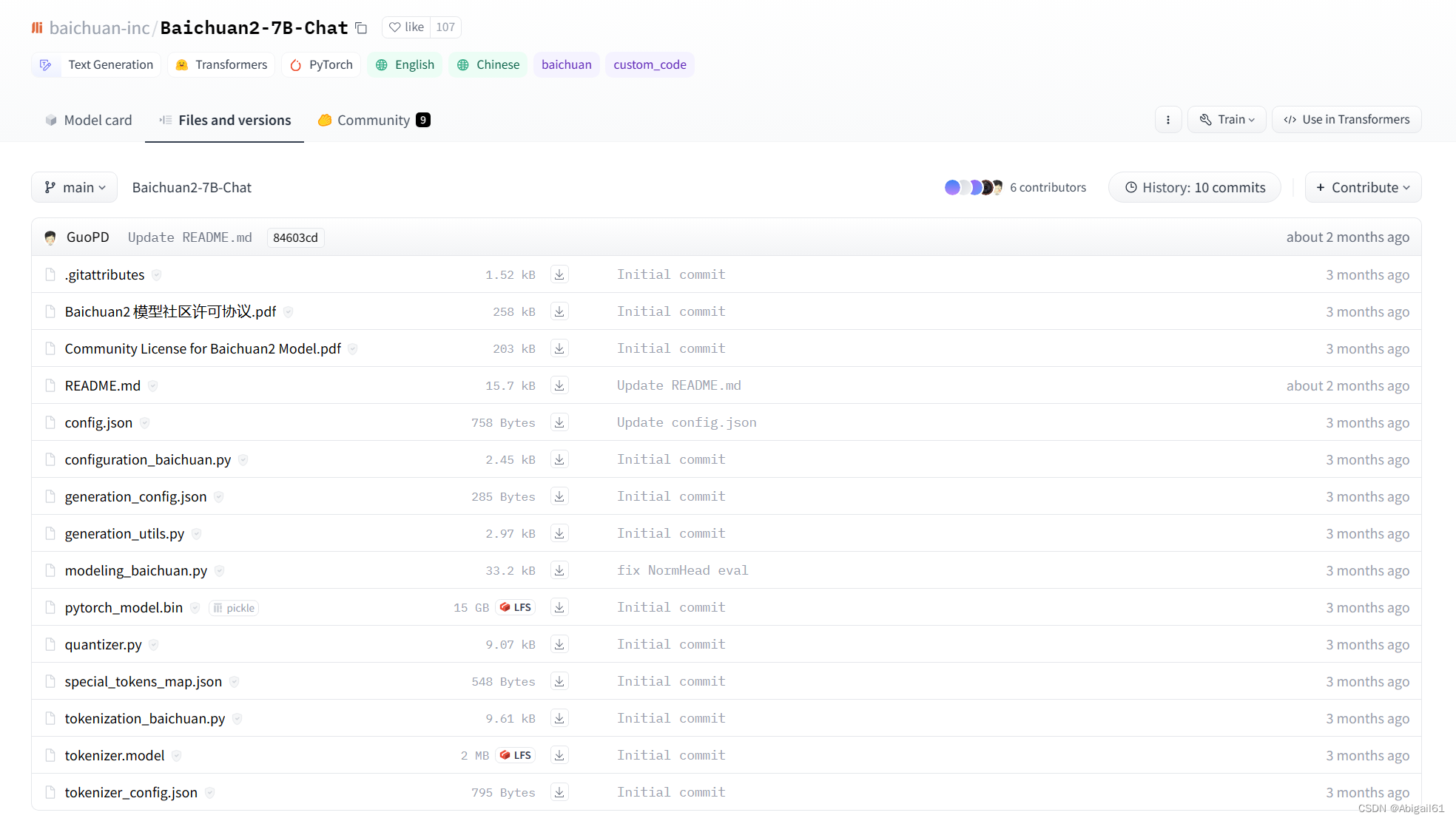

【不推荐】下载方式1:手动从huggingface界面下载相应文件

从huggingface官网挨个下载文件。这种方式需要先下载模型到本地,再上传到服务器上,经过两次传输,很是麻烦。不推荐。

当然如果你只是需要部分文件,就可以这样手动点击下载你需要的几个文件。

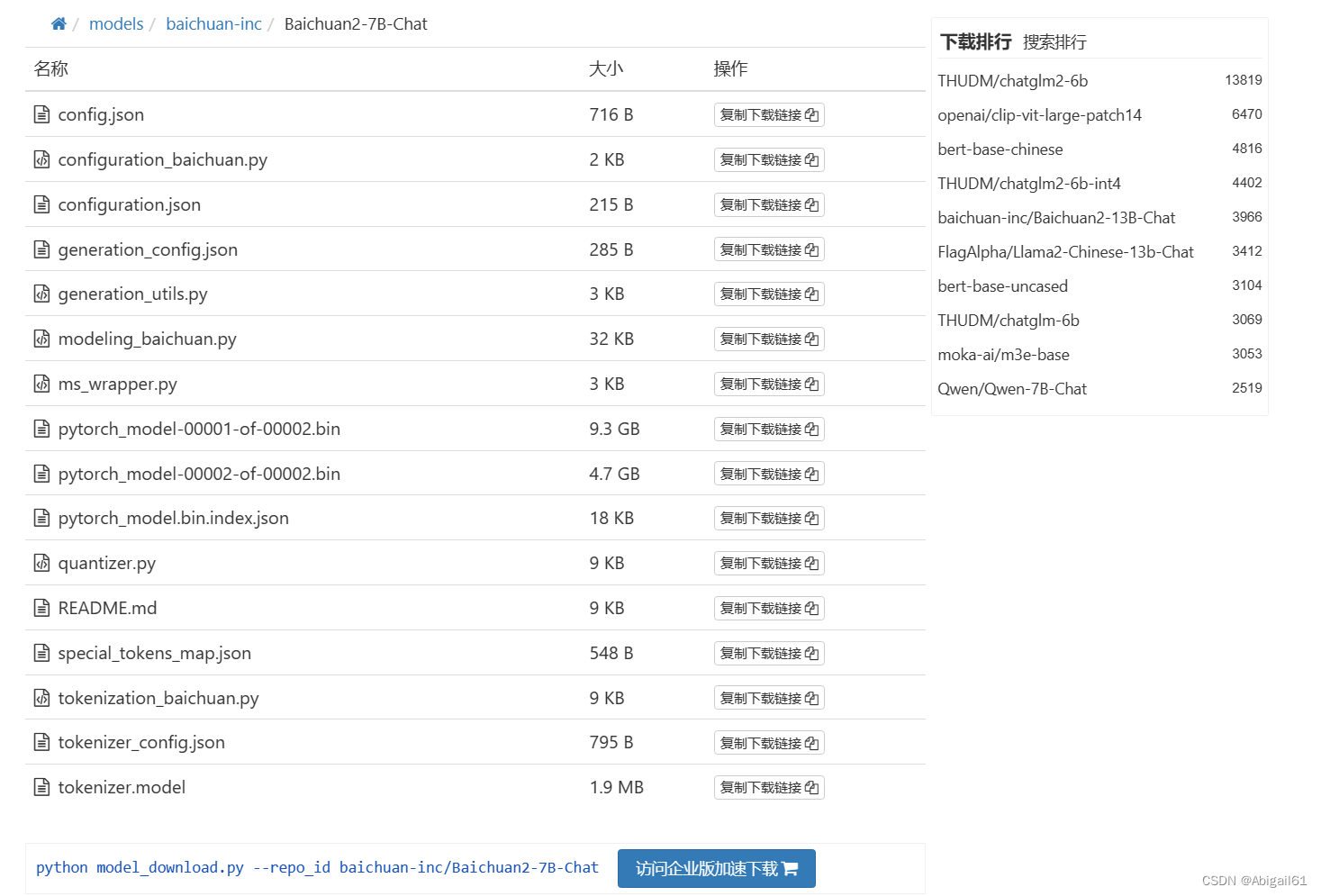

【一般推荐】下载方式2 使用下载器下载

去huggingface 镜像网站, 先将图中的model_download.py文件下载到服务器里。

下载代码为:

wget https://aliendao.cn/model_download.py

然后运行代码:

pip install huggingface_hub python model_download.py --repo_id (模型ID)

不知道模型ID的可以去搜索栏搜索模型名称,比如baichuan2-7B-Chat

例如,我们如果要下载Baichuan2-7B-Chat模型,就执行下面这行代码。

python model_download.py --repo_id baichuan-inc/Baichuan2-7B-Chat

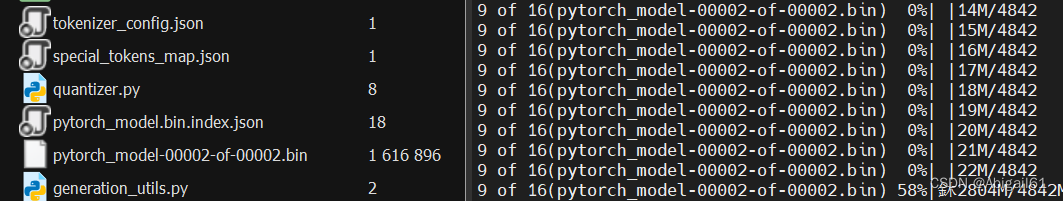

这样就能直接在服务器上下载huggingface模型了,而且会显示下载进度条。速度大约是2M/s

温馨提示

模型下载通常要很久,别忘了打开tmux窗口防止电脑休眠导致网络中断哦

如果你忘了打开tmux窗口也没关系,可以按ctrl-z暂停任务,再打开tmux,重新运行python model_download.py --repo_id 模型id 这行下载代码,可继续下载

【非常推荐】下载方式3 使用huggingface-cli脚本下载

- 首先在linux中输入

export HF_ENDPOINT=https://hf-mirror.com

- 然后执行

source .bashrc

- 下载huggingface-cli

pip install huggingface-cli

- 准备好你的模型存放路径,以及需要下载的模型id(在huggingface页面复制),执行下面的代码,即可大功告成~ 这种方式下载速度比2快

huggingface-cli download --resume-download (模型名称) --local-dir (模型存放位置) --local-dir-use-symlinks False --resume-download

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们,邮箱:ciyunidc@ciyunshuju.com。本站只作为美观性配图使用,无任何非法侵犯第三方意图,一切解释权归图片著作权方,本站不承担任何责任。如有恶意碰瓷者,必当奉陪到底严惩不贷!