Hadoop 2.0:主流开源云架构(一)

目录

- 一、引例

- (一)问题概述

- (二)常规解决方案

- (三)分布式下的解决方案

- (四)小结

自从云计算的概念被提出,不断地有IT厂商推出自己的云计算平台,但它们都是商业性平台,对于想要继续研究和发展云计算技术的个人和科研团体来说,无法获得更多的了解,Hadoop的出现给研究者带来了希望。

一、引例

(一)问题概述

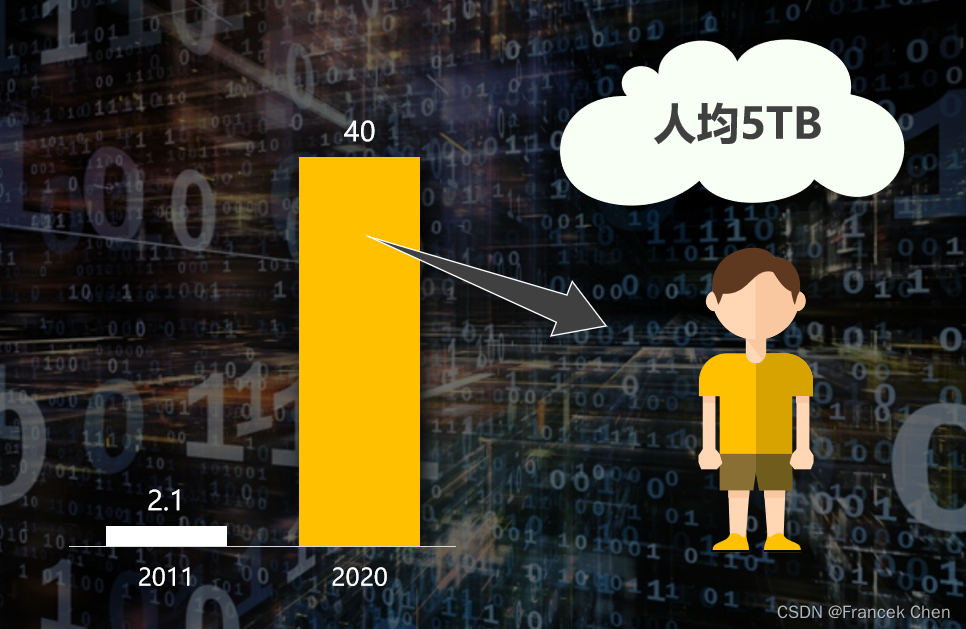

【例1】 假设现有一些配置完全相同的机器cSlave0~cSlaveN,cMaster0,cMaster1,并且每台机器都有1个双核CPU,5GB硬盘。现有两个大小都是2GB的文件file0和file1。

第一类问题,存储。

问题①:将file0和file1存入两台不同机器,但要求对外显示它们存于同一硬盘空间。

问题②:不考虑①,现有一新文件file2,大小为6GB,要求存入机器后对外显示依旧为一个完整文件。

第二类问题,计算。

问题③:在问题①下,统计file0和file1这两个文件里每个单词出现的次数。

第三类问题,可靠性。

问题④:假设用于解决上述问题的机器宕机了,问如何保证数据不丢失。

(二)常规解决方案

问题①解答:取两台机器cSlave0和cSlave1,cSlave0存储file0,cSlave1存储file1。

问题②解答:将file2拆成两个大小分别为3GB的文件file2-a和file2-b,将file2-a存入cSlave0、file2-b存入cSlave1。

问题③解答:

步骤一,将cSlave1上的file1复制一份到cSlave0上,这样cSlave0上同时存有file0和file1。

步骤二,编写一简单程序,程序里使用HashMap,顺序读取文件,判断新读取的单词是否存在于HashMap,存在Integer+1,不存在则HashMap里加入这个新单词,Integer置为1,记此程序为WordCount。

步骤三,将此程序WordCount放在cSlave0上执行,得出结果。

问题④解答:为每台机器都做磁盘冗余阵列(RAID),购买更稳定的硬件,配置最好的机房、最稳定的网络。

(三)分布式下的解决方案

上述方案并没有真正解决问题,下面介绍的分布式方案也是Hadoop的架构思路:

1、分布式存储

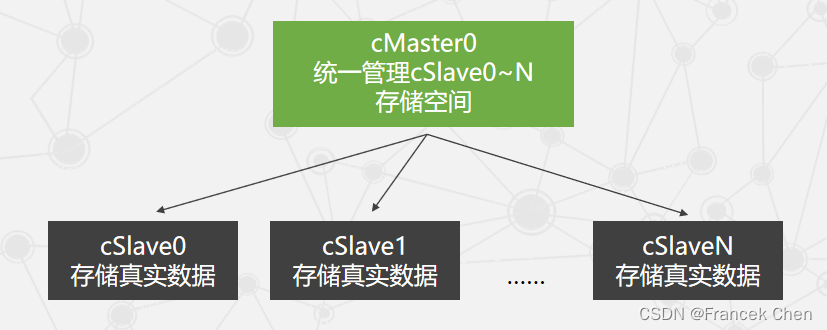

对于第一类存储问题,若能将多台机器硬盘以某种方式连接到一起,则问题迎刃而解。取机器cSlave0,cSlave1和cMaster0,采用客户-服务器模式构建分布式存储集群,让cMaster0管理cSlave0,cSlave1。

经过上述方式构建的集群,对内,采用客户-服务器模式,只要保证store master正常工作,我们很容易随意添加store slave,硬盘存储空间无限大。对外,统一存储空间,统一文件接口,整个集群就像是一台机器、一片云,硬盘显示为统一存储空间,文件接口统一。

称此构建的文件系统为分布式文件系统(Distributed File System,DFS),Hadoop分布式文件系统(Hadoop DFS,HDFS)的架构思想和上述过程类似。

2、分布式计算

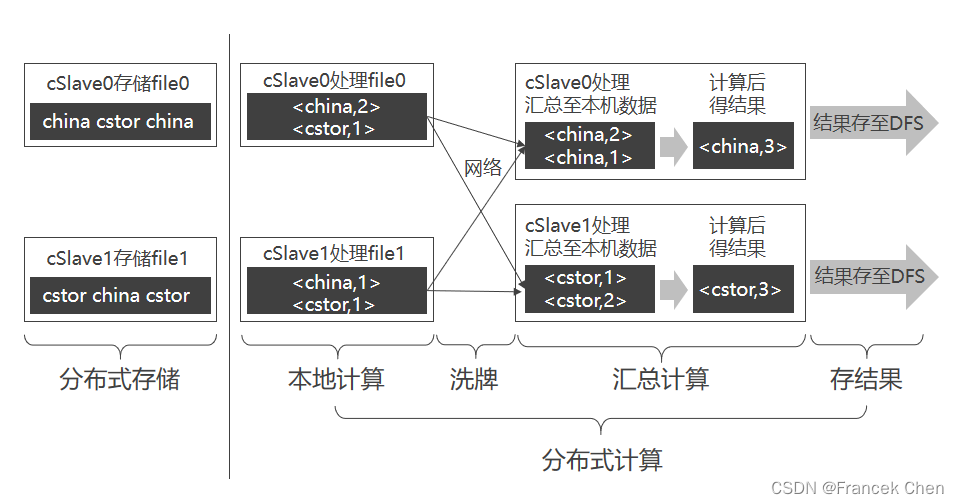

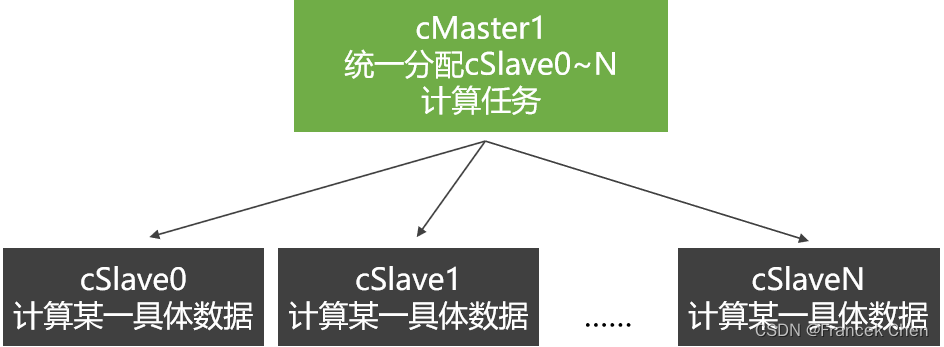

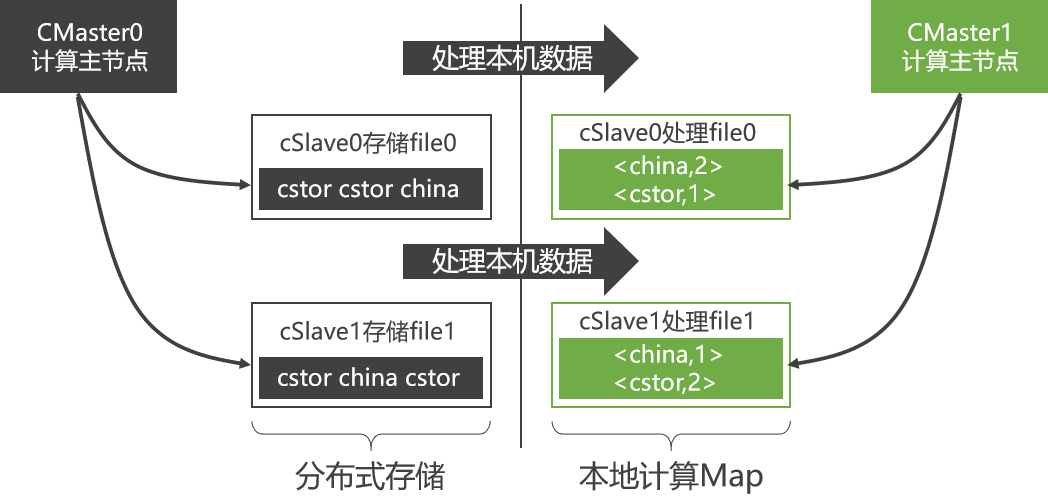

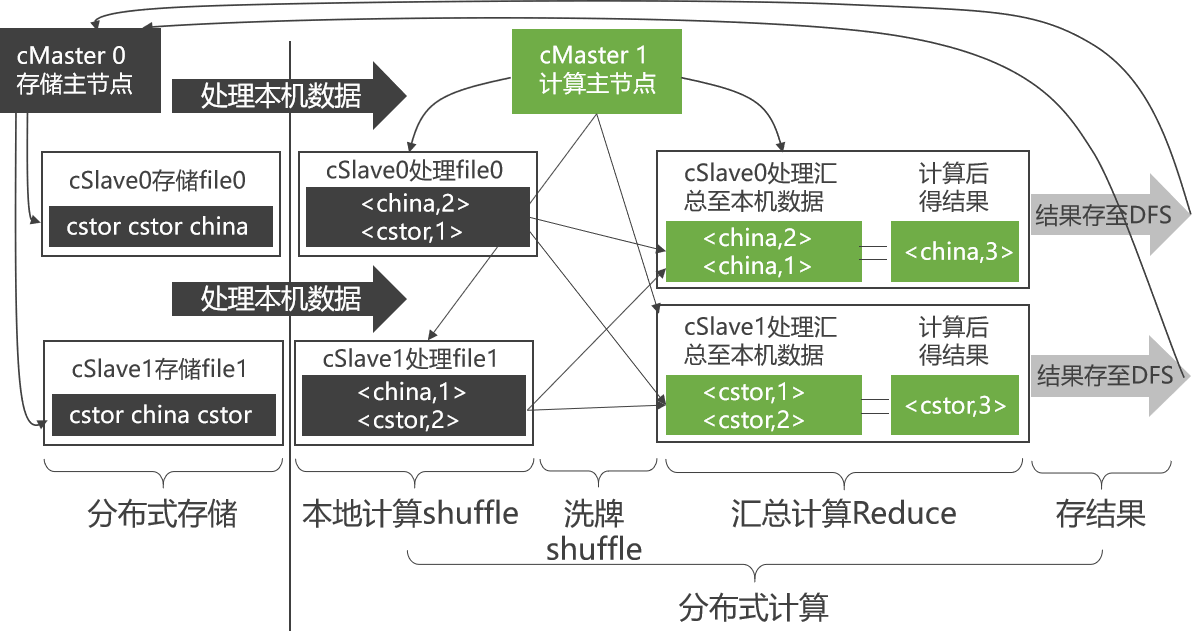

处理过程可分为三步:本地计算(Map)、洗牌(Shuffle)和合并再计算(Reduce)。取新机器cMaster1,采用客户-服务器模式构建由机器cSlave0、cSlave1和cMaster1组成的分布式计算集群。

cSlave0最好是处理存于本机硬盘上的file0,而不是将file1从cSlave1调过来(通过网络)再处理file1,这就是所谓的“本地计算”。

如何能够实现“合并”过程也由多机执行?由此引入“洗牌”(Shuffle)过程,即规定将Key值相同的KV对,通过网络发往同一台机器。

- 第一步,每台机器将各自KV对中的Value连接成一个链表。

- 第二步,各台机器可对进行业务处理,称此过程为Reduce。

- 第三步,将得出的结果再存于DFS。

容易看出,无论是Map、Shuffle还是Reduce,甚至是存储结果,在每个阶段都是并行的,整个过程则构成一个有向无环图(DAG)。

3、冗余存储与冗余计算

只要保证存于cSlave0上的数据,同时还存在于别的机器上,即使cSlave0宕机,数据依旧不会丢失。

存储时,引入新机器cSlave2和cSlave3,将存于cSlave0的file0同样存储于cSlave2,存于cSlave1的file1同样存一份于cSlave3。计算时,cSlave0~3的计算任务统一由cMaster1指派。cMaster1选中先结束的那台机器的计算结果,并停止另一台机器里还在计算的进程。

作用:通过冗余存储,不仅提高了分布式存储可靠性,还提高了分布式计算的可靠性。

(四)小结