论文笔记:A Simple and Effective Pruning Approach for Large Language Models

iclr 2024 reviewer 评分 5668

1 intro

- 大模型网络剪枝的paper

- 在努力保持性能的同时,舍弃网络权重的一个子集

- 现有方法

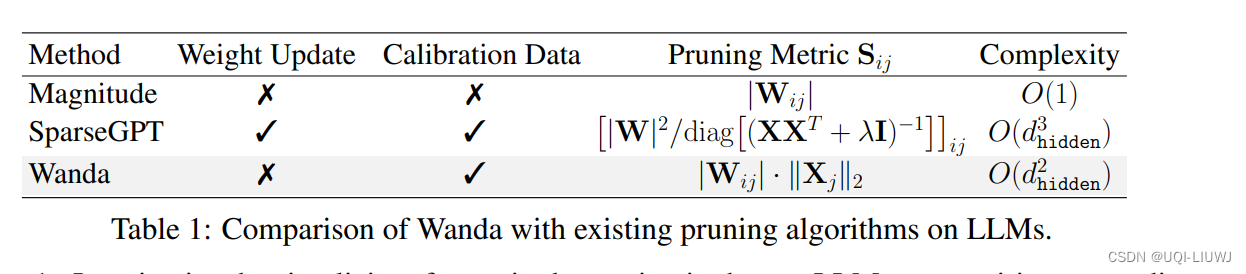

- 要么需要重新训练

- 这对于十亿级别的LLMs来说往往不现实

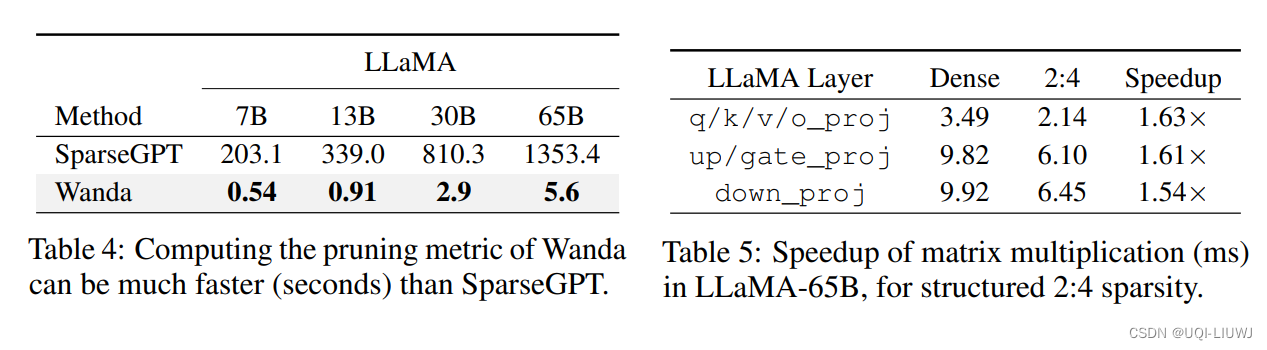

- 要么需要解决依赖于二阶信息的权重重建问题

- 这同样可能带来高昂的计算成本

- 要么需要重新训练

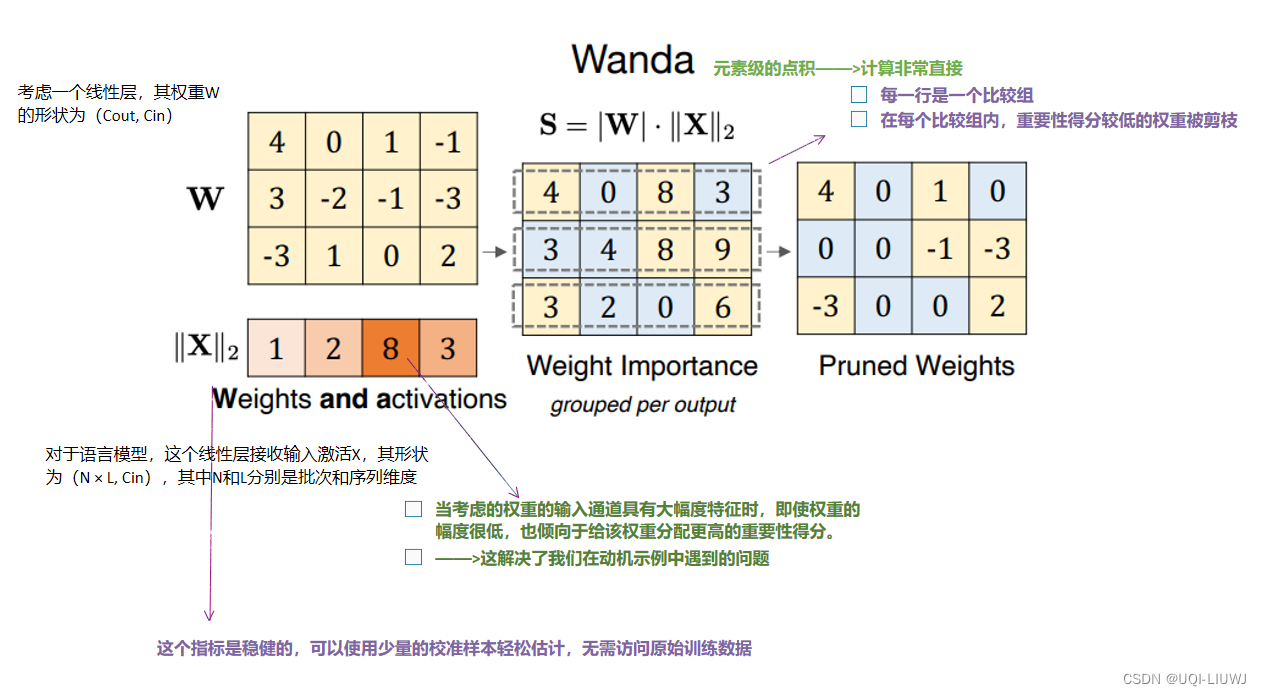

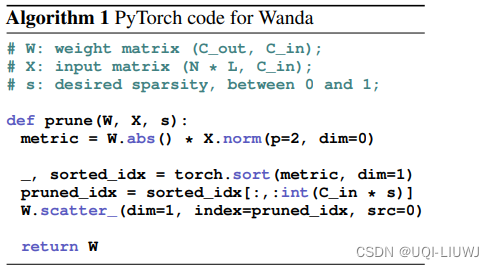

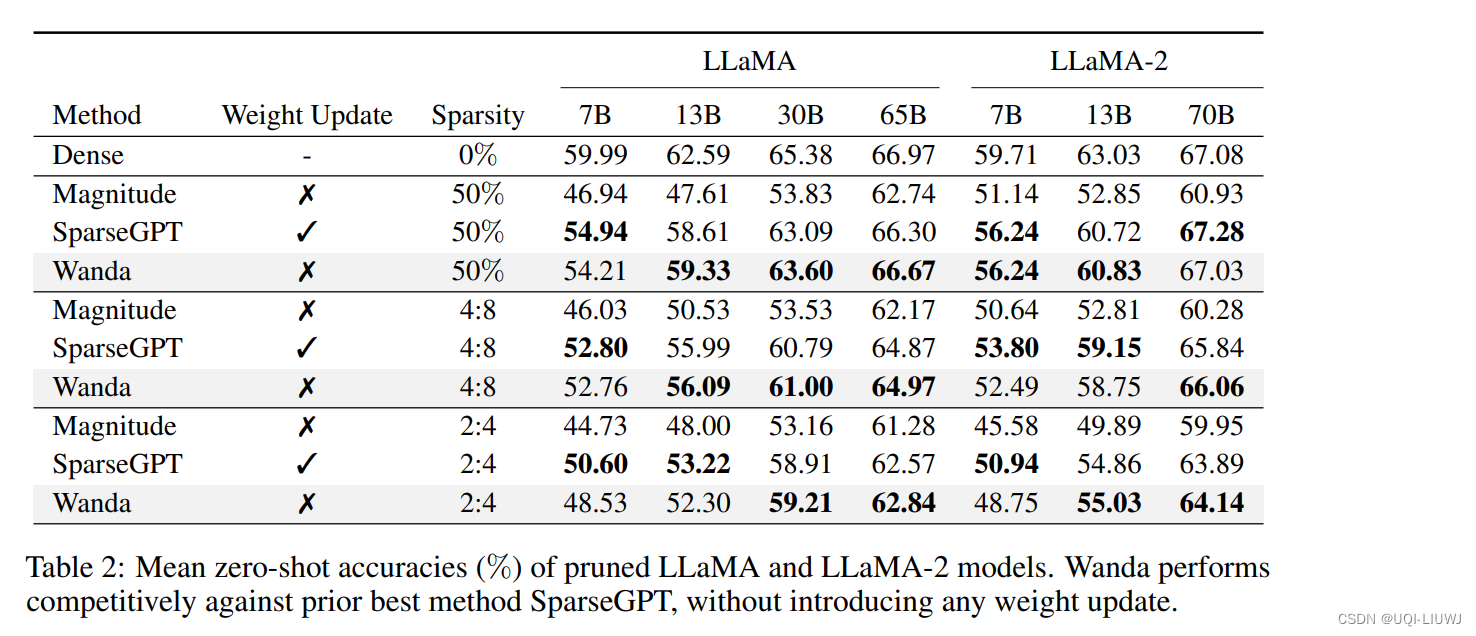

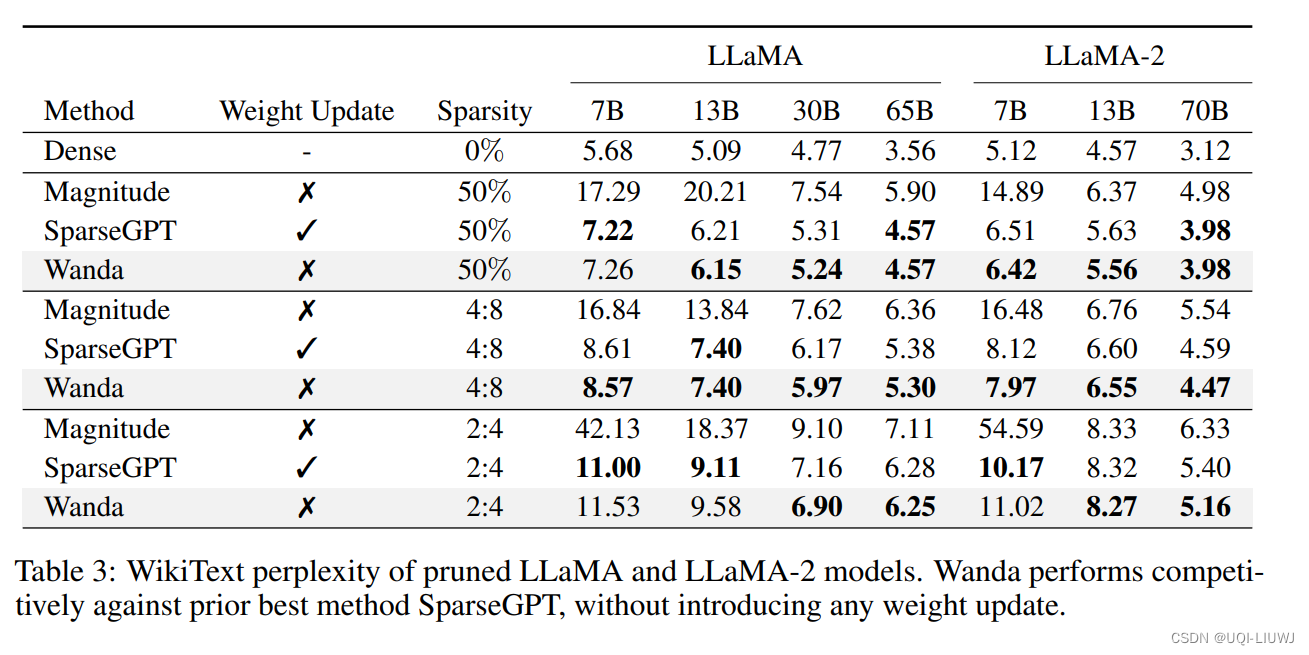

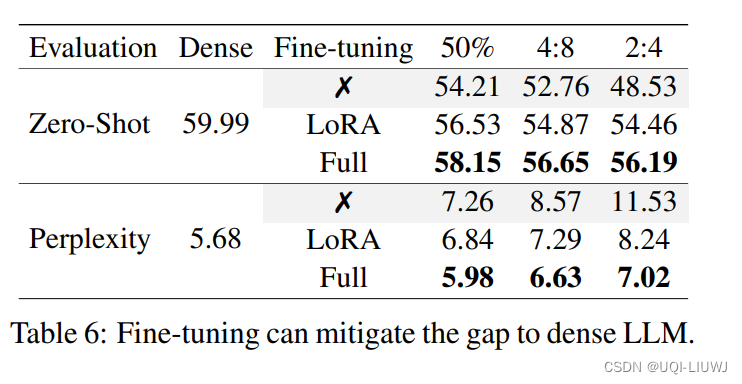

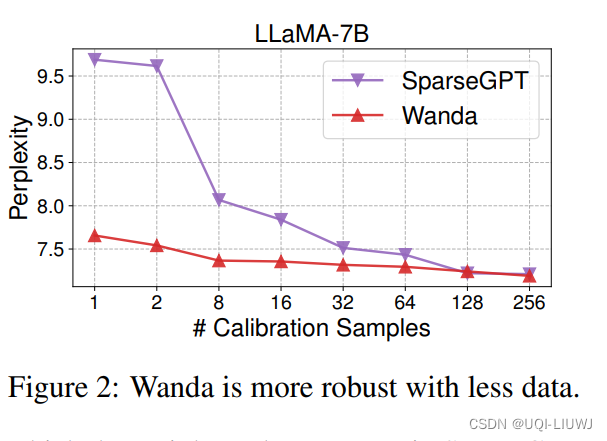

- ——>引入了一种新颖、简单且有效的剪枝方法,名为Wanda (Pruning by Weights and activations)

- 在每个输出的基础上,剪枝那些乘以相应输入激活后幅度最小的权重

- 无需重新训练或权重更新,剪枝后的LLM可以即刻使用

2 方法

2.1 motivation

- 考虑一个带有两个输入及其对应权重的神经元:y = w1x1 + w2x2,其中|w1| ≤ |w2|。

- 现在假设目标是选择一个权重进行移除,同时使输出变化最小。

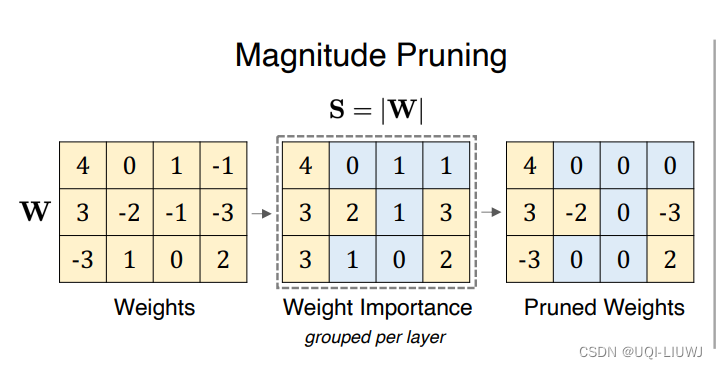

- 标准的幅度剪枝方法总是会移除权重w1

- 如果输入特征x1和x2的幅度相似,这可能是一个好策略。

- 然而,最近在LLMs中观察到,两个输入特征的规模可能差异很大。例如,可能|x1| ≫ |x2|,结果是|w1x1| ≫ |w2x2|。

- 在这种情况下,我们应该移除权重w2,因为这种移除明显对神经元输出y的影响小于移除权重w1。

免责声明:我们致力于保护作者版权,注重分享,被刊用文章因无法核实真实出处,未能及时与作者取得联系,或有版权异议的,请联系管理员,我们会立即处理! 部分文章是来自自研大数据AI进行生成,内容摘自(百度百科,百度知道,头条百科,中国民法典,刑法,牛津词典,新华词典,汉语词典,国家院校,科普平台)等数据,内容仅供学习参考,不准确地方联系删除处理! 图片声明:本站部分配图来自人工智能系统AI生成,觅知网授权图片,PxHere摄影无版权图库和百度,360,搜狗等多加搜索引擎自动关键词搜索配图,如有侵权的图片,请第一时间联系我们,邮箱:ciyunidc@ciyunshuju.com。本站只作为美观性配图使用,无任何非法侵犯第三方意图,一切解释权归图片著作权方,本站不承担任何责任。如有恶意碰瓷者,必当奉陪到底严惩不贷!