Jamba:AI21 实验室发布首个应用级的 Mamba 架构 AI 模型

AI21 实验室发布了 Jamba,这是全球首个基于 Mamba 架构的、可用于实际应用的 AI 模型。目前大多数模型(例如 GPT、Gemini 和 Llama)都基于 Transformer 架构。Jamba 结合了 Mamba 结构化状态空间模型 (SSM) 和传统 Transformer 架构的优点,实现了性能和效率的显著提升。

Jamba 拥有 256K 个 Token 的超长文本处理能力,相当于大约 210 页文本,同时可在单个 80GB 的 GPU 上容纳 140K 个 token。这一突破得益于其混合 SSM-Transformer 架构,该架构利用混合专家 (MoE) 技术,在进行推算时仅调用其 520 亿个参数中的 120 亿个。这意味着 Jamba 比大多数同类模型能够处理更长的文本,例如 Meta 的 Llama 2 的文本处理能力为 32,000 个词元,同时 Jamba 还保持着高吞吐量和效率。

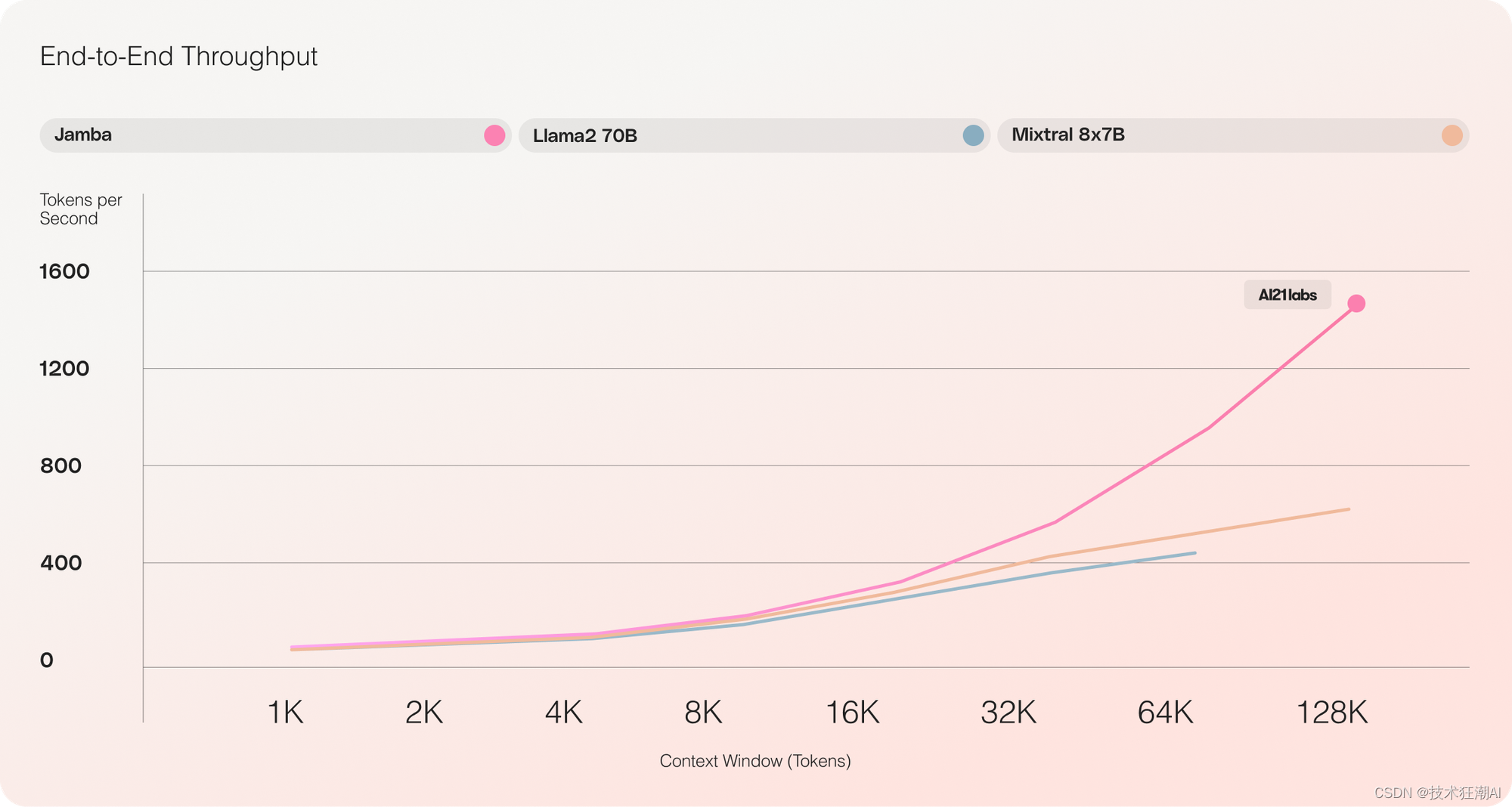

Jamba 在处理长文本时,其吞吐量是同等规模的 Transformer 模型(例如 Mixtral 8x7B)的三倍。

Jamba 的一大优势是,在处理长文本时,其吞吐量是同等规模的 Transformer 模型(例如 Mixtral 8x7B)的三倍。这得益于其独特的混合架构,该架构由 Transformer、Mamba 和混合专家 (MoE) 层组成,可同时优化内存占用、吞吐量和性能。

Jamba 采用模块化设计,每个模块包含一个注意力层或一个 Mamba 层,以及一个多层感知器 (MLP)。这意味着 Transformer 层在所有层级中的占比仅为八分之一。AI21 实验室表示,这种设计能够让 Jamba 在单个 GPU 上最大限度地提高运算质量和吞吐量,同时为常见的推理任务留出充足的内存空间。

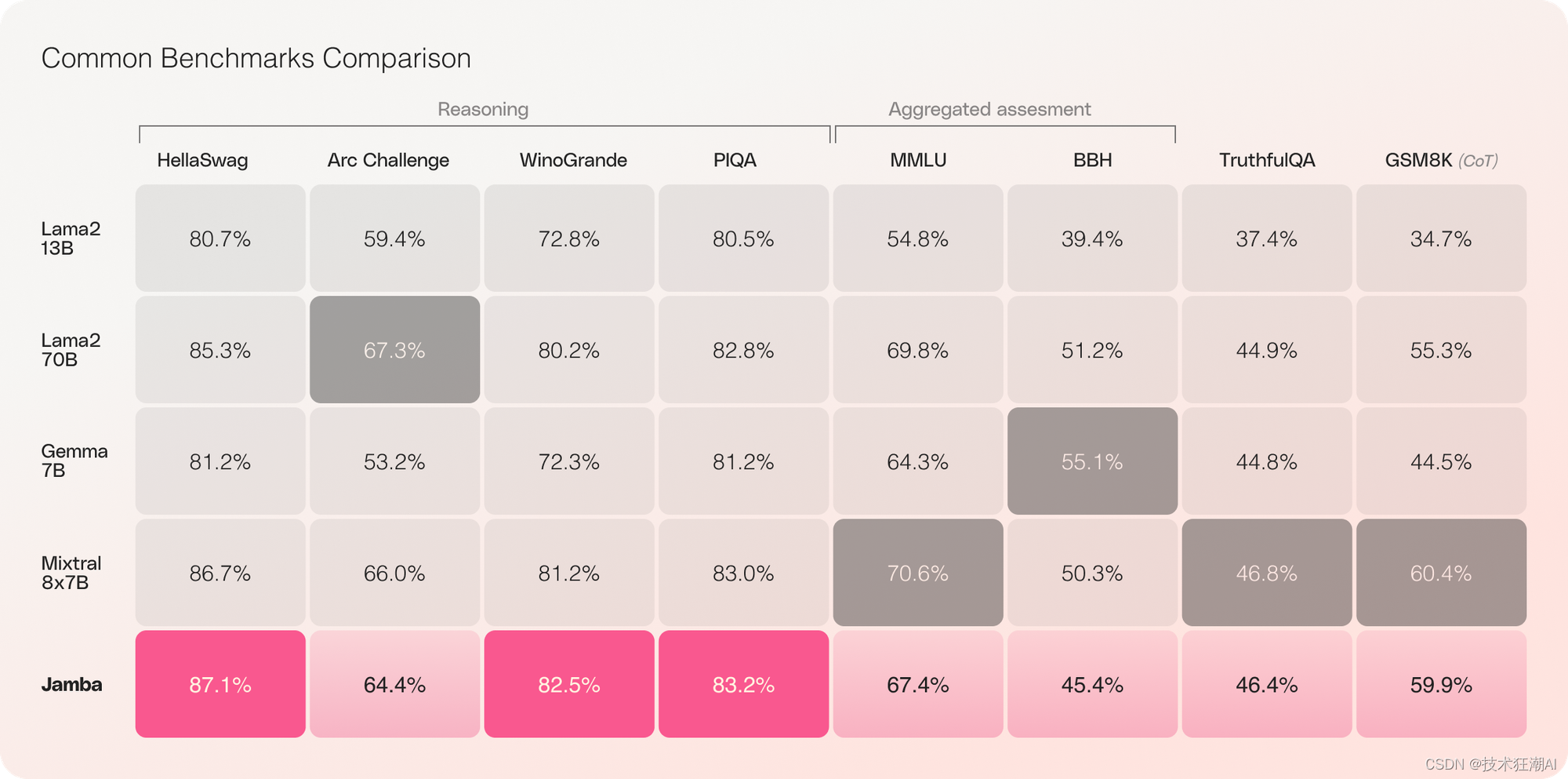

Jamba 的出色性能不仅体现在效率和成本效益上。该模型已经在各种基准测试中展现出优异的结果,在同等规模的模型中,Jamba 在各类任务上的表现均达到或超越了目前最先进的模型。

Jamba 在各项测试中表现优异,在同等规模的模型中,其性能超越或比肩其他最先进的模型。

Jamba 以开源形式发布,任何人都可以免费使用和修改。它可以通过 Hugging Face 平台获取,也可以作为 NVIDIA NIM 推理微服务,通过 NVIDIA AI Enterprise 软件平台进行部署。这意味着开发者可以轻松地将 Jamba 应用于各种应用程序中。

目前,Jamba 作为一个研究模型发布,尚未经过针对商业应用的安全性和可靠性优化。不过,AI21 实验室计划在未来几周内发布一个经过微调、更加安全可靠的版本。随着 AI 社区不断探索和改进新的架构,我们可以预期 AI 模型在性能、效率和可访问性方面取得更大的进步,这将为新一代更强大的 AI 应用铺平道路。

HuluAI ,主打三大刚需场景:AI对话 , AI写作 和 AI绘画 。目前已经有几万个用户了,运行非常稳定。

目前HuluAI集成了 市面上常用的大模型:ChatGPT4.0、Midjourney、Dall·E3、文心一言4.0、Gemini(最新上线)后续还会陆续增加新的模型。

HuluAI还在根据用户的需求,不断更新上线新的功能!比如 图片解析、图片融合 等等常用功能 。目前图片融合功能正在内测中,可以将人物和背景无缝融合,预计本月就会上线。

活动价最后3天时间,3天后永久会员的价格会 从298元直接涨到498元。并且逐步取消永久会员。

✔ 在线使用地址:https://h5.cxyhub.com/?invitation=bskVIt

References

[1]. Jamba: https://huggingface.co/ai21labs/Jamba-v0.1

[2]. Mamba: https://arxiv.org/pdf/2312.00752.pdf

[3]. NVIDIA API catalog: http://ai.nvidia.com/

[4]. NVIDIA NIM: https://developer.nvidia.com/blog/nvidia-nim-offers-optimized-inference-microservices-for-deploying-ai-models-at-scale

[5]. NVIDIA AI Enterprise software: https://nvidianews.nvidia.com/news/generative-ai-microservices-for-developers